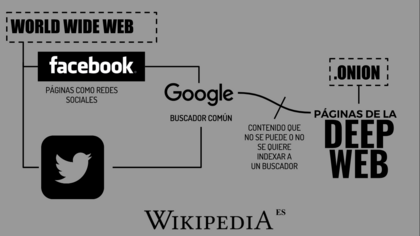

Internet profunda1 (del inglés, deep web), internet invisible2 o internet oculta3 es el contenido de internet que no está indexado por los motores de búsquedaconvencionales, debido a diversos factores.4 El término se atribuye al informático Mike Bergman.5 Es el opuesto al Internet superficial.

Índice

Origen[editar]

La principal causa de la existencia de la internet profunda es la imposibilidad de los motores de búsqueda (Google, Yahoo, Bing, etc.) de encontrar o indexar gran parte de la información existente en Internet. Si los buscadores tuvieran la capacidad para acceder a toda la información entonces la magnitud de la «internet profunda» se reduciría casi en su totalidad. No obstante, aunque los motores de búsqueda pudieran indexar la información de la internet profunda esto no significaría que esta dejara de existir, ya que siempre existirán las páginas privadas. Los motores de búsqueda no pueden acceder a la información de estas páginas y sólo determinados usuarios, aquellos con contraseñas o códigos especiales, pueden hacerlo.

En la Deep Web pueden establecerse contactos que no son monitoreados, nadie está allí observando. Además las transferencias tanto de mercancía como de pagos son prácticamente imposible de rastrear. La web está dividida en dos partes, la web superficial y la web profunda. Esta última es la que se conoce como Deep Web, donde se ubica todo contenido que no es indexable por los buscadores, o al que los usuarios no pueden acceder mediante un buscador web como DuckDuckGo, Startpage, Yandex, Ecosia, Yahoo!, Google o Bing.

La internet profunda no es una región prohibida o mística de internet, y la tecnología relacionada con ella por lo general no es conspirativa, peligrosa o ilegal. En ella se alberga todo tipo de recurso al que se es difícil de acceder mediante métodos comunes como los motores de búsqueda populares.

Una parte de la internet profunda consiste en redes internas de instituciones científicas y académicas que forman la denominada Academic Invisible Web: («Internet académica invisible») la cual se refiere a las bases de datos que contienen avances tecnológicos, publicaciones científicas, y material académico en general a los cuales no se pueden acceder fácilmente.6

Tamaño[editar]

La internet profunda es un conjunto de sitios web y bases de datos que buscadores comunes no pueden encontrar ya que no están indexadas. El contenido que se puede hallar dentro de la internet profunda es muy amplio7.

El internet se ve dividido en dos ramas, la internet profunda y la superficial. La internet superficial se compone de páginas indexadas en servidores DNS con una alfabetización y codificación de página perfectamente entendible por los motores de búsqueda, mientras que la internet profunda está compuesta de páginas cuyos dominios están registrados con extensiones .onion y los nombres de los dominios están codificados en una trama HASH. Estas páginas se sirven de forma ad hoc, y no necesitan registrarse, basta con que tu ordenador tenga funcionando un servicio onion, que hará las veces de un servicio dns, pero especial para las páginas del internet profundo. Mediante una red P2P, se replican las bases de datos que contienen la resolución de nombres HASH.

Mientras que las páginas normales son identificadas mediante el protocolo UDP/IP, las páginas .onion son repetidas por el ramal al que se ha conectado el navegador especializado para tal sistema de navegación segura. El sistema de búsqueda es el mismo que usa BitTorrent. El contenido se coloca en una base de datos y se proporciona sólo cuando lo solicite el usuario.8

En 2010 se estimó que la información que se encuentra en la internet profunda es de 7500 terabytes, lo que equivale a aproximadamente 550 billones de documentos individuales. El contenido de la internet profunda es de 400 a 550 veces mayor de lo que se puede encontrar en la internet superficial. En comparación, se estima que la internet superficial contiene solo 19 terabytes de contenido y un billón de documentos individuales.

También en 2010 se estimó que existían más de 200 000 sitios en la internet profunda.9

Estimaciones basadas en la extrapolación de un estudio de la Universidad de California en Berkeley especula que actualmente la internet profunda debe tener unos 91 000 terabytes.10

La Association for Computing Machinery (ACM) publicó en 2007 que Google y Yahoo indexaban el 32 % de los objetos de la internet profunda, y MSN tenía la cobertura más pequeña con el 11 %. Sin embargo, la cobertura de los tres motores era de 37 %, lo que indicaba que estaban indexando casi los mismos objetos.11

Motivos[editar]

Motivos por los que los motores de búsqueda no pueden indexar algunas páginas:

- Web contextual: páginas cuyo contenido varía dependiendo del contexto (por ejemplo, la dirección IP del cliente, de las visitas anteriores, etc.).

- Contenido dinámico: páginas dinámicas obtenidas como respuesta a parámetros, por ejemplo, datos enviados a través de un formulario.

- Contenido de acceso restringido: páginas protegidas con contraseña, contenido protegido por un Captcha, etc.

- Contenido No HTML: contenido textual en archivos multimedia, otras extensiones como exe, rar, zip, etc.

- Software: Contenido oculto intencionadamente, que requiere un programa o protocolo específico para poder acceder (ejemplos: Tor, I2P, Freenet)

- Páginas no enlazadas: páginas de cuya existencia no tienen referencia los buscadores; por ejemplo, páginas que no tienen enlaces desde otras páginas.

Denominación[editar]

Son páginas de texto, archivos, o en ocasiones información a la cual se puede acceder por medio de la World Wide Web que los buscadores de uso general no pueden, debido a limitaciones o deliberadamente, agregar a sus índices de páginas web.

La Web profunda se refiere a la colección de sitios o bases de datos que un buscador común, como Google, no puede o no quiere indexar. Es un lugar específico del internet que se distingue por el anonimato. Nada que se haga en esta zona puede ser asociado con la identidad de uno, a menos que uno lo desee.12

Bergman, en un artículo semanal sobre la Web profunda publicado en el Journal of Electronic Publishing, mencionó que Jill Ellsworth utilizó el término «Web invisible» en 1994 para referirse a los sitios web que no están registrados por ningún motor de búsqueda.13

Sería un sitio que, posiblemente esté diseñado razonablemente, pero no se molestaron en registrarlo en alguno de los motores de búsqueda. ¡Por lo tanto, nadie puede encontrarlos! Estás oculto. Yo llamo a esto la Web invisible.

Otro uso temprano del término Web Invisible o web profunda fue por Bruce Monte y Mateo B. Koll de Personal Library Software, en una descripción de la herramienta @ 1 de web profunda, en un comunicado de prensa de diciembre de 1996.15

La importancia potencial de las bases de datos de búsqueda también se reflejó en el primer sitio de búsqueda dedicado a ellos, el motor AT1 que se anunció a bombo y platillo a principios de 1997. Sin embargo, PLS, propietario de AT1, fue adquirida por AOL en 1998, y poco después el servicio AT1 fue abandonado.13

El primer uso del término específico de web profunda, ahora generalmente aceptada, ocurrió en el estudio de Bergman de 2001 mencionado anteriormente.

Por otra parte, el término web invisible se dice que es inexacto porque:

- Muchos usuarios asumen que la única forma de acceder a la web es consultando un buscador.

- Alguna información puede ser encontrada más fácilmente que otra, pero esto no quiere decir que esté invisible.

- La web contiene información de diversos tipos que es almacenada y recuperada en diferentes formas.

- El contenido indexado por los buscadores de la web es almacenado también en bases de datos y disponible solamente a través de las peticiones o consultas del usuario, por tanto no es correcto decir que la información almacenada en bases de datos es invisible.16

Rastreando la internet profunda[editar]

Los motores de búsqueda comerciales han comenzado a explorar métodos alternativos para rastrear la Web profunda. El Protocolo del sitio (primero desarrollado e introducido por Google en 2005) y OAI son mecanismos que permiten a los motores de búsqueda y otras partes interesadas descubrir recursos de la internet profunda en los servidores web en particular. Ambos mecanismos permiten que los servidores web anuncien las direcciones URL que se puede acceder a ellos, lo que permite la detección automática de los recursos que no están directamente vinculados a la Web de la superficie. El sistema de búsqueda de la Web profunda de Google pre-calcula las entregas de cada formulario HTML y agrega a las páginas HTML resultantes en el índice del motor de búsqueda de Google. Los resultados surgidos arrojaron mil consultas por segundo al contenido de la Web profunda.17 Este sistema se realiza utilizando tres algoritmos claves:

- La selección de valores de entrada, para que las entradas de búsqueda de texto acepten palabras clave.

- La identificación de los insumos que aceptan solo valores específicos (por ejemplo, fecha).

- La selección de un pequeño número de combinaciones de entrada que generan URLs adecuadas para su inclusión en el índice de búsqueda Web.

Métodos de profundización[editar]

Las arañas (web crawlers)[editar]

Cuando se ingresa a un buscador y se realiza una consulta, el buscador no recorre la totalidad de internet en busca de las posibles respuestas, sino que busca en su propia base de datos, que ha sido generada e indexada previamente. Se utiliza el término «araña web» (en inglés web crawler) o robots (por software, comúnmente llamados "bots") inteligentes que van haciendo búsquedas por enlaces de hipertexto de página en página, registrando la información ahí disponible.18

Cuando una persona realiza una consulta, el buscador no recorre la totalidad de internet en busca de las posibles respuestas, lo cual supondría una capacidad de reacción bastante lenta. Lo que hace es buscar en su propia base de datos, que ha sido generada e indizada previamente. En sus labores de búsqueda, indización y catalogación, utilizan las llamadas arañas (o robots inteligentes) que van saltando de una página web a otra siguiendo los enlaces de hipertexto y registran la información allí disponible.

[...] datos que se generan en tiempo real, como pueden ser valores de Bolsa, información del tiempo, horarios de trenes.

El contenido que existe dentro de la internet profunda es en muy raras ocasiones mostrado como resultado en los motores de búsqueda, ya que las «arañas» no rastrean bases de datos ni los extraen. Las arañas no pueden tener acceso a páginas protegidas con contraseñas, algunos desarrolladores que no desean que sus páginas sean encontradas insertan etiquetas especiales en el código para evitar que sea indexada. Las «arañas» son incapaces de mostrar páginas que no estén creadas en lenguaje HTML, ni tampoco puede leer enlaces que incluyen un signo de interrogación. Pero ahora sitios web no creados con HTML o con signos de interrogación están siendo indexados por algunos motores de búsqueda. Sin embargo, se calcula que incluso con estos buscadores más avanzados solo se logra alcanzar el 16 % de la información disponible en la internet profunda. Existen diferentes técnicas de búsqueda para extraer contenido de la internet profunda como librerías de bases de datos o simplemente conocer el URL al que quieres acceder y escribirlo manualmente.19

Tor[editar]

The Onion Router (abreviado como TOR) es un proyecto diseñado e implementado por la marina de los Estados Unidos lanzado el 20 de septiembre de 2002. Posteriormente fue patrocinado por la EFF (Electronic Frontier Foundation, una organización en defensa de los derechos digitales). Al presente (2018), subsiste como TOR Project, una organización sin ánimo de lucro galardonada en 2011 por la Free Software Foundation por permitir que millones de personas en el mundo tengan libertad de acceso y expresión en internet manteniendo su privacidad y anonimato.20

A diferencia de los navegadores de internet convencionales, Tor le permite a los usuarios navegar por la Web de forma anónima. Tor es descargado de 30 millones a 50 millones de veces al año, hay 0,8 millones de usuarios diarios de Tor y un incremento del 20 % solamente en 2013. Tor puede acceder a unos 6 500 sitios web ocultos.21

Cuando se ejecuta el software de Tor, para acceder a la internet profunda, los datos de la computadora se cifran en capas. El software envía los datos a través de una red de enlaces a otros equipos ―llamados en inglés «relays» (‘nodos’)― y lo va retransmitiendo quitando una capa antes de retransmitirlo de nuevo, esta trayectoria cambia con frecuencia. Tor cuenta con más de 4 000 retransmisiones y todos los datos cifrados pasan a través de ―por lo menos― tres de estos relays. Una vez que la última capa de cifrado es retirado por un nodo de salida, se conecta a la página web que desea visitar.

El contenido que puede ser encontrado dentro de la internet profunda es muy vasto, se encuentran por ejemplo, datos que se generan en tiempo real, como pueden ser valores de Bolsa, información del tiempo, horarios de trenes, bases de datos sobre agencias de inteligencia, disidentes políticos y contenidos criminales.18

Criptomoneda[editar]

Es posible encontrar sitios web que realicen transacciones ilegales (como drogas, armas, o incluso asesinos a sueldo) en servidores exclusivos para usuarios de Tor. Es una práctica común utilizar monedas digitales como el Bitcoin20 que se intercambia a través de billeteras digitales entre el usuario y el vendedor, lo que hace que sea prácticamente imposible de rastrear.22

Recursos de la internet profunda[editar]

Los recursos de la internet profunda pueden estar clasificados en las siguientes categorías:

- Contenido de acceso limitado: los sitios que limitan el acceso a sus páginas de una manera técnica (Por ejemplo, utilizando el estándar de exclusión de robots o captcha, que prohíben los motores de búsqueda de la navegación por y la creación de copias en caché.23

- Contenido dinámico: las páginas dinámicas que devuelven respuesta a una pregunta presentada o acceder a través de un formulario, especialmente si se utilizan elementos de entrada en el dominio abierto como campos de texto.

- Contenido no enlazado: páginas que no están conectadas con otras páginas, que pueden impedir que los programas de rastreo web tengan acceso al contenido. Este material se conoce como páginas sin enlaces entrantes.

- Contenido programado: páginas que solo son accesibles a través de enlaces producidos por JavaScript, así como el contenido descargado de manera dinámica a partir de los servidores web a través de soluciones de Flash o Ajax.

- Sin contenido HTML: contenido textual codificado en multimedia (imagen o video) archivos o formatos de archivo específicos no tratados por los motores de búsqueda.

- Web privada: los sitios que requieren de registro y de una contraseña para iniciar sesión

- Web contextual: páginas con contenidos diferentes para diferentes contextos de acceso (por ejemplo, los rangos de direcciones IP de clientes o secuencia de navegación anterior).

fuente: wikipedia